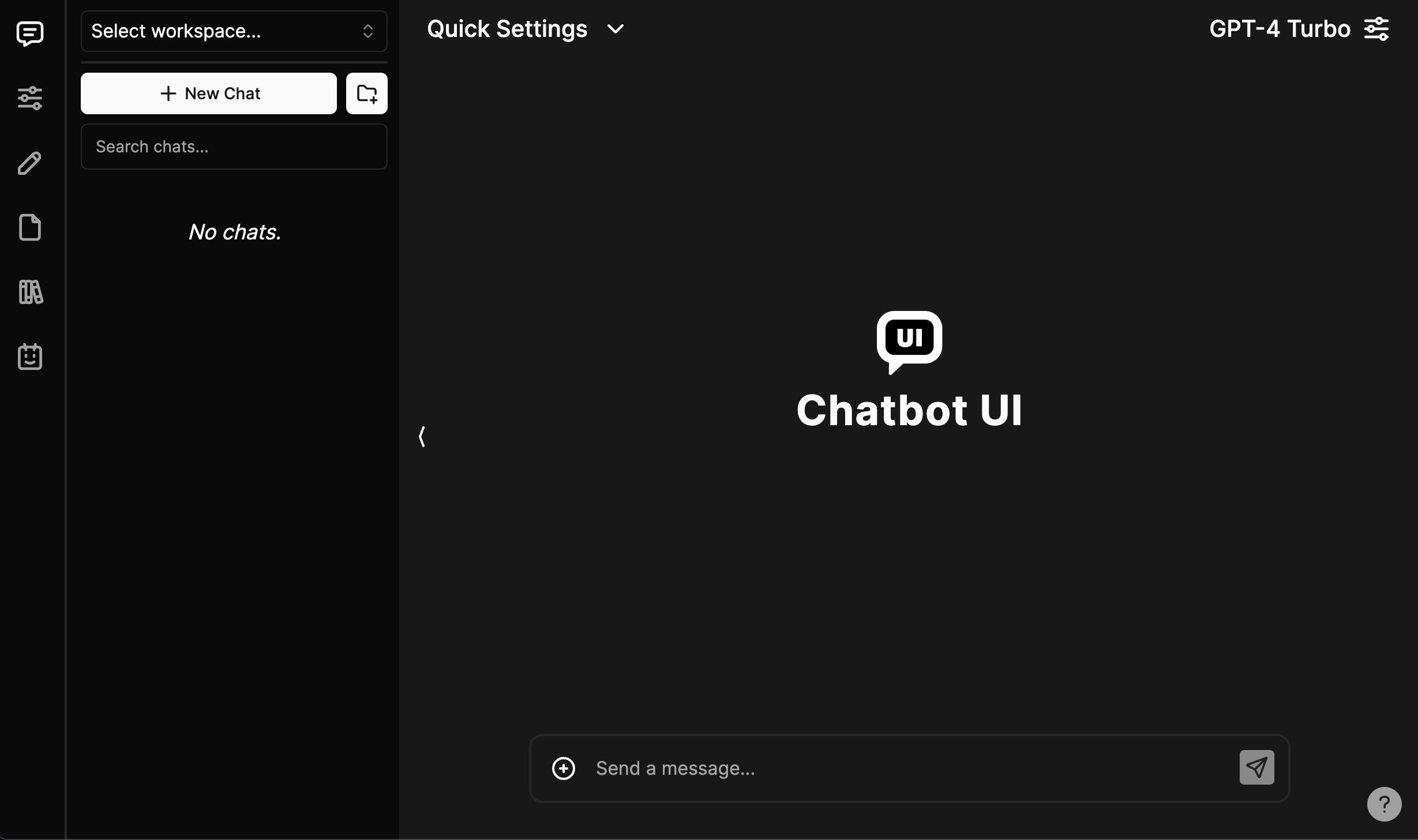

本地快速入门

请按照以下步骤操作,让您自己的 Chatbot UI 实例在本地运行。

您可以在此处观看完整的视频教程。

1. 克隆存储库

git clone https://github.com/mckaywrigley/chatbot-ui.git

2.安装依赖项

在本地 Chatbot UI 存储库的根目录中打开终端并运行:

npm install``

3.安装Supabase并在本地运行

为什么是Supabase?

以前,我们使用本地浏览器存储来存储数据。然而,由于以下几个原因,这不是一个好的解决方案:

安全问题

存储空间有限

限制多模式用例

我们现在使用 Supabase,因为它易于使用,它是开源的,它是 Postgres,并且它有一个用于托管实例的免费层。

未来我们将支持其他提供商,为您提供更多选择。

1.安装Docker

您需要安装 Docker 才能在本地运行 Supabase。您可以在这里免费下载。

2.安装Supabase CLI

MacOS/Linux

brew install supabase/tap/supabase

或者直接下载https://github.com/supabase/cli/releases/tag/v1.162.6

sudo dpkg -i supabase_1.162.6_linux_amd64.deb``

Windows

scoop bucket add supabase https://github.com/supabase/scoop-bucket.git scoop install supabase

3.启动Supabase

在本地 Chatbot UI 存储库根目录的终端中,运行:

supabase start

4. 填写秘密

1.环境变量

在本地 Chatbot UI 存储库根目录的终端中,运行:

cp .env.local.example .env.local

通过运行获取所需的值:

supabase status

注意:使用API URLfrom supabase statusforNEXT_PUBLIC_SUPABASE_URL

现在转到您的.env.local文件并填写值。

如果设置了环境变量,它将禁用用户设置中的输入。

5.安装Ollama(本地型号可选)

docker run -d -v ollama:/root/.ollama -p 11434:11434 --name ollama ollama/ollama

6.本地运行应用程序

在本地 Chatbot UI 存储库根目录的终端中,运行:

npm run chat

您的 Chatbot UI 本地实例现在应该在http://localhost:3000上运行。请务必使用兼容的节点版本(即 v18)